pgmr.cloud

20 August 2023

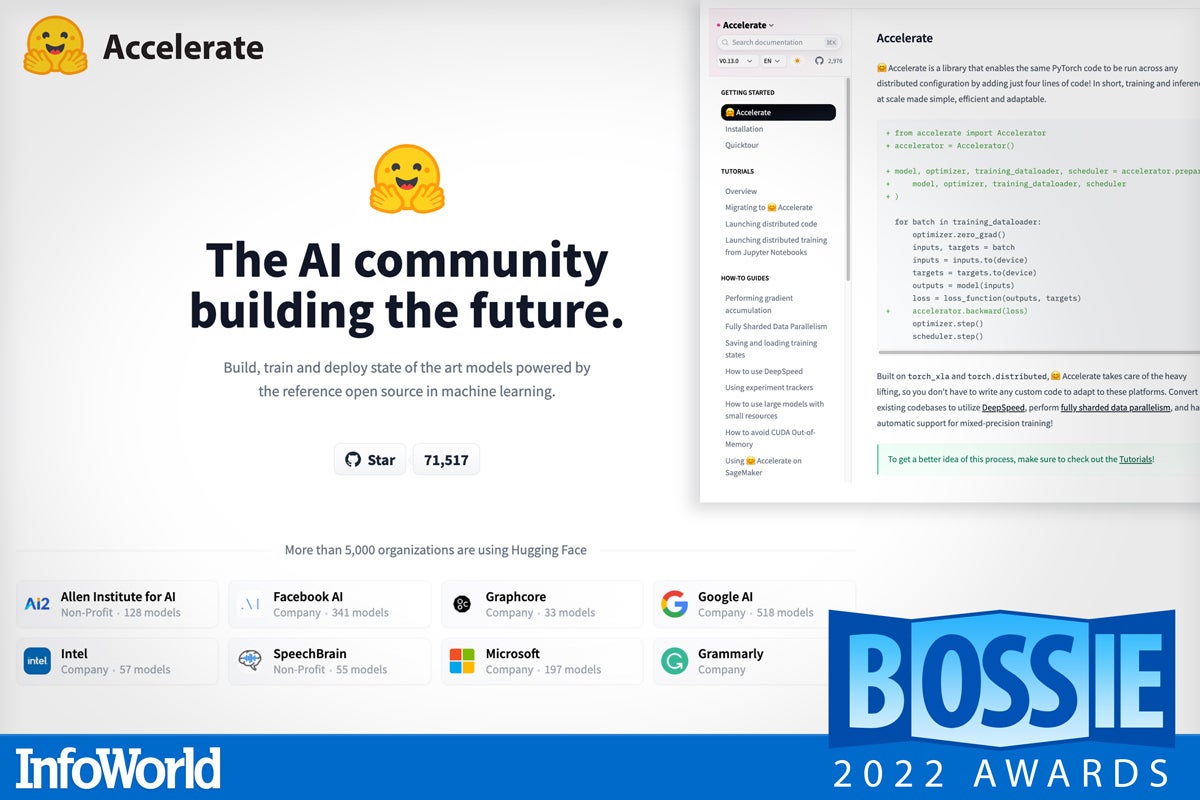

如果只需添加四行代码,就可以将大规模的分布式训练和推理添加到任何PyTorch代码中,会怎么样?Huggingface的Accelerate开箱即用,允许您通过简单的配置开关使用TPU设备或微软的DeepSpeed优化等功能。是的,您可以使用分布式训练、分片并行和梯度积累等技术,在十亿参数规模上训练深度学习模型,所有这些都由Accelerate库在幕后处理。确保大模特的培训不仅限于行业中的重量级人物,这对多样性和实验性很重要,因此看到Accelerate成为PyTorch生态系统的一部分令人振奋。

——Ian Pointer

- 登录 发表评论